De opiniesite van BNNVARA met actueel nieuws en uitgesproken meningen

De coronacrisis als stresstest

•

98 keer bekeken

•

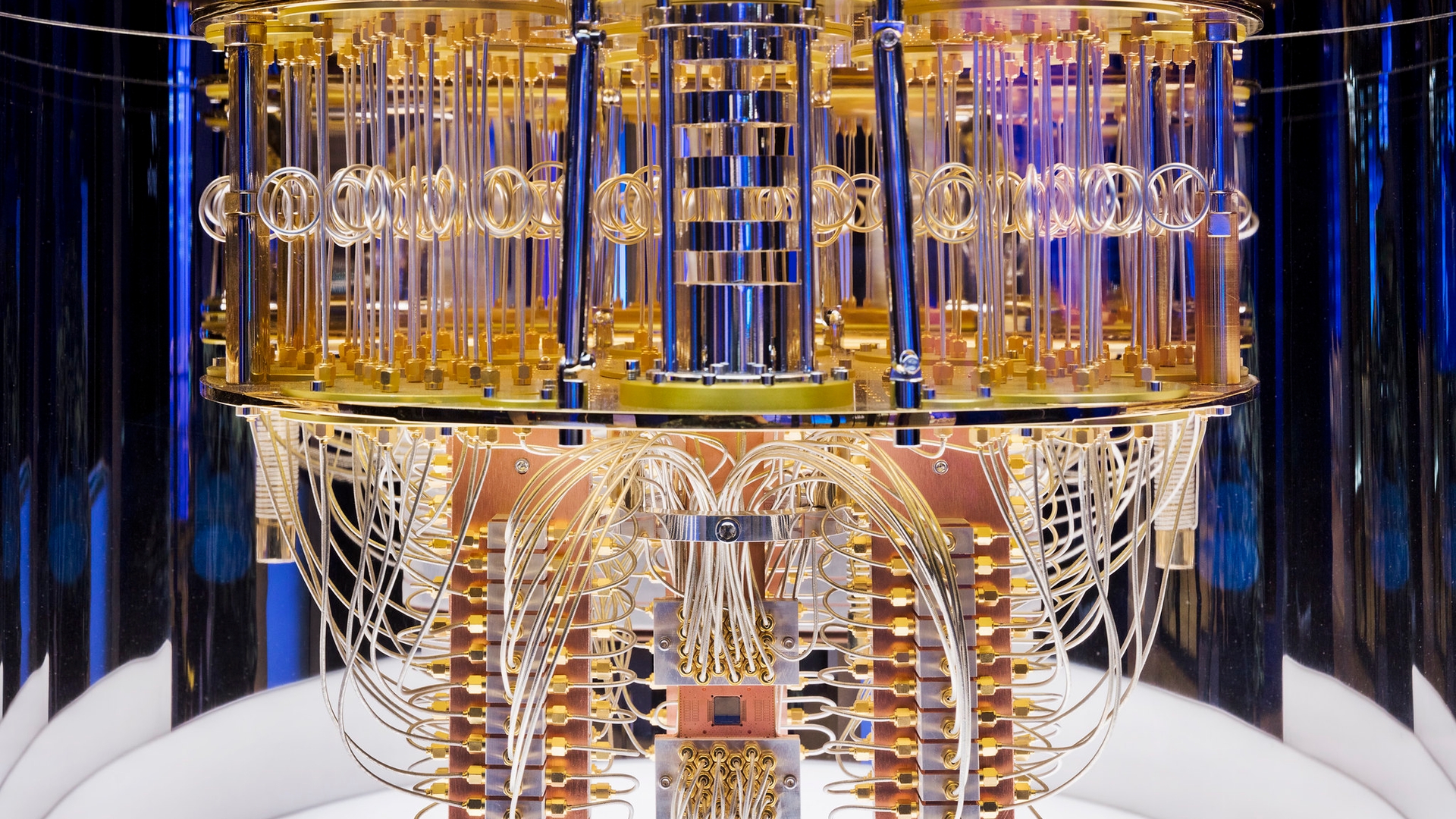

© cc-foto: IBM Research

Corona is een ramp, maar in de 21e eeuw kan de mensheid met grotere bedreigingen geconfronteerd raken. En niet alleen in de vorm van pandemieën.

Ruben Mersch trachtte onlangs in een artikel voor De Correspondent het optimisme over een vaccin tegen corona te temperen. Laten we echter aannemen dat het lukt om binnen onafzienbare tijd vrijwel de gehele wereldbevolking te vaccineren. Zijn we dan van het probleem af?

Een virus volledig opruimen is een kwestie van een lange adem. Het kan zo lang duren dat tegen de tijd waarop het doel in zicht is de volgende pandemie zich alweer aandient. Lijkt overdreven, maar de laatste honderd jaar kende acht influenzapandemieën. Corona is niet de eerste pandemie en zal niet de laatste zijn. Bovendien vrezen virologen dat pandemieën elkaar sneller zullen opvolgen. Als gevolg van de toegenomen bevolkingsdichtheid, waardoor de afstand tot het dierenrijk is afgenomen en zoönose virussen eenvoudiger op de mens kunnen overspringen.

De impact van een volgende pandemie valt moeilijk te voorspellen. De Spaanse griep doodde in de jaren na 1918 tussen twintig tot veertig miljoen mensen, maar in 2002 bij de uitbraak van het H5N1-virus – beter bekend als het vogelgriepvirus – bleef het aantal dodelijke slachtoffers beperkt tot 400.

Toch is H5N1 bloedlink. Dat het niet meer slachtoffers (onder mensen) eiste komt omdat het zich, in tegenstelling tot het coronavirus, niet eenvoudig in menselijke longen nestelt. Onmogelijk is dat laatste echter niet en gebeurde vooral bij mensen die veel contact met vogels hadden. Bij besmetting van de mens met H5N1 noemt de WHO een sterftegraad van 60 procent, een cijfer dat doet denken aan de pest in de Middeleeuwen.

Virologen zijn beducht voor een gemuteerd H5N1-virus, waar de mens even snel mee besmet raakt als met het coronavirus. De viroloog Ron Fouchier van het Erasmus Medisch Centrum in Rotterdam weet hoe weinig daar voor nodig is. Om een gemuteerd vogelgriepvirus eenvoudiger onder dieren te kunnen signaleren ontwikkelde hij met slechts een paar mutaties een besmettelijker variant van H5N1.

Daarmee nam Fouchier een risico, want geen laboratorium is honderd procent veilig. Er zijn geen indicaties dat het coronavirus uit een laboratorium wist te ontsnappen, maar wel degelijk meldingen over ongelukken in laboratoria waar met virussen wordt gewerkt. Zo raakten in 2003 medewerkers van een laboratorium in Hongkong met het SARS-virus besmet en er zijn meer laboratoria waar het fout ging.

Existentiële risico’s De Australische filosoof Toby Ord werkt voor het aan de Oxford Universiteit verbonden Future of Humanity Institute. Daar bestudeert hij existential risks , factoren die tot het einde van de mensheid leiden, of deze onherstelbare schade kunnen toebrengen. Zelfs laboratoria met de hoogste veiligheidsnorm (BSL-4) bieden volgens Ord geen volledige waarborg. Dat weegt zwaar voor hem, omdat hij via biotechnologie ontwikkelde virussen tot de grootste bedreigingen van de mensheid in 21e eeuw rekent.

Corona leidt tot enorme problemen op tal van gebieden, maar is geen existential risk. Ord meent dat we de situatie aan zouden moeten grijpen om ons voor te bereiden op de nog extremere risicofactoren, die volgens hem in het verschiet liggen en ons wél op het pad van de dodo en de dinosauriërs kunnen plaatsen. Naast de bekende factoren als pandemieën overweegt Ord risico’s waar de mens geen ervaring mee heeft, maar die desalniettemin veel zwaardere gevolgen zouden hebben dan corona. Daar dienen we ons naar zijn mening nu op voor te bereiden. Ord beschouwt de coronacrisis met andere woorden als een stresstest voor een mensheid die nog veel meer voor de kiezen zal krijgen.

Supervaccin Genoemde viroloog Fouchier droomt van een vaccin dat de toekomstige mens tegen meerdere virussen kan beschermen, maar verwacht niet dat het er binnen twintig jaar zal komen. De ontwikkeling van een vaccin kan inderdaad erg lang duren. Daarbij speelt de vraag of dit supervaccin er ooit zal komen met de technologie die de wetenschap momenteel ter beschikking staat.

Een forse handicap is het gebrek aan rekenvermogen van computers. Zeker, er worden supercomputers ingezet om vaccins te ontwerpen, maar door de beperkingen daarvan blijven ellenlange trials noodzakelijk om effectiviteit en bijwerkingen vast te kunnen stellen. Aan de horizon verschijnt soelaas: de quantum computer. De ontwikkeling daarvan bevindt zich in een vroeg stadium. Quantum supremacy , de doorbraak waarbij de quantumcomputer taken uit kan voeren waar een conventionele supercomputer het opgeeft, is nog niet bereikt (Google claimde quantum supremacy , maar werd door IBM terechtgewezen). Innovatie op dit gebied (ook in Nederland ) zit echter zwaar in de lift.

Qbits Het gaat te ver om de quantum computer hier diepgaand uit te leggen. Het is een wonderlijke machine, gebaseerd op aspecten uit de quantum mechanica als superposition en entanglement. Het binaire concept van conventionele computers wordt hier vervangen door Qbits , die tegelijkertijd 0 en 1 kunnen zijn. Het wordt pas 0 of 1 wanneer ‘de golffunctie instort’, oftewel wanneer een bewustzijn het veld betreedt. Knotsgek verhaal, maar het resultaat is een computer met een dramatisch verhoogd rekenvermogen.

Met het aantal Qbits groeit het rekenvermogen exponentieel: het aantal bits van een quantum computer met rond de 280 Qbits staat in verhouding gelijk aan het aantal atomen in het universum! Het zal nog wel even duren voordat dit mogelijk wordt, maar op kortere termijn kunnen er met een quantumcomputer naar verwachting wel al berekeningen worden gedaan waar de huidige generatie supercomputers van terugdeinst. Zoals het berekenen van moleculen: vaccins kunnen op moleculair niveau ontwikkeld worden, zonder de noodzaak van tijd slopende trials.

Artificial General Intelligence De coronacrisis wordt recentelijk genoemd als argument in het voordeel van de quantumcomputer. Dat is echter eerder een illustratie van waar dit bijzonder apparaat in de toekomst toe in staat zou kunnen zijn, want het is duidelijk dat de quantumcomputer er niet op tijd zal zijn om een vaccin tegen het coronavirus te ontwikkelen. De ontwikkelingen gaan zoals gesteld snel, maar net niet snel genoeg. Daardoor blijft de wetenschap voor een coronavaccin aangewezen op conventionele methoden.

Realistischer wordt het ten aanzien van pandemieën die de mensheid verderop in de 21 e eeuw kunnen treffen. De quantumcomputer zal dan een aanmerkelijk aandeel kunnen leveren aan de ontwikkeling van een supervaccin. Bovendien kan de quantumcomputer dan ook antwoorden vinden op andere dringende vragen. Denk bijvoorbeeld aan berekeningen over het klimaat die zo complex zijn dat conventionele supercomputers het al snel opgeven.

Het addertje De quantumcomputer zal daarnaast een niet in te schatten impuls bieden aan de ontwikkeling van kunstmatige intelligentie (AI). En dan niet de betrekkelijk simpele algoritmes waar Google en Facebook giganten nu mee werken om zoveel mogelijk opbrengsten uit advertenties te kunnen genereren, maar Artificial General Intelligence (AGI), de superintelligentie die ons in de toekomst veel werk en beslissingen uit handen gaat nemen en de wereld daardoor grondig zal veranderen.

De quantumcomputer en AI zijn afzonderlijke grootheden binnen de cybertechnologie, maar kunnen tegelijkertijd niet los van elkaar gezien worden. Het is onvoorstelbaar dat AI tot volledige wasdom kan komen binnen een infrastructuur zonder quantumcomputers. AGI zou alleen al door de razendsnelle groei van de hoeveelheid data snel tegen de beperkingen van conventionele supercomputers aan lopen.

Kortom, we kunnen de quantumcomputer extra stimuleren om ons uit de problemen te helpen wat betreft pandemieën, maar de consequentie is dan dat het AGI-tijdperk erdoor naderbij komt. Daar zit het addertje onder het gras, want genoemde Toby Ord van het Future of Humanity Institute ziet unaligned AGI als een van de grootste bedreigingen van de mensheid. Een intelligentie groter dan die van mensheid beschouwt hij als een gevaar voor het voortbestaan daarvan. Bijvoorbeeld wanneer de superintelligentie bij het uitvoeren van zijn taak zoveel beslag legt op grondstoffen dat er voor de mens niets overblijft. Of wanneer de superintelligentie de mens zelf als grondstof gaat beschouwen! (zie het Paperclip Maximizer gedachte-experiment)

Ord schat het risico van anthropogenic risks als een atoomoorlog, klimaatverandering, of pandemieën als gevolg van doelbewust ontwikkelde ziekteverwekkers veel hoger in dan dat van een natuurlijke dreigingen, zoals een catastrofale supernova, asteroïde, of vulkaanuitbarsting (waarvan de kans overigens een stuk groter is dan een Doomsday Asteroid ). Binnen de anthropogenic risks krijgt het risico van AGI echter een erg hoge notering bij Ord.

Moet er, omdat de komst van superintelligentie erdoor zal accelereren dan maar een streep worden gezet door de ontwikkeling van de quantum computer? Nee, zeker niet. Toby Ord is de eerste om te erkennen dat AGI de mensheid enorme mogelijkheden kan bieden; mogelijkheden die de hemel op aarde onder bereik brengen. Het einde van pandemieën is daar niet meer dan een klein voorbeeld van. De belofte van AGI gaat veel verder, tot het einde van de dood aan toe.

Kansberekening Om volop profijt te kunnen trekken uit AGI is het zaak te voorkomen dat we er de controle over verliezen. Dit betekent dat de superintelligentie zich volgens menselijke morele en ethische normen dient te gedragen. De vraag hoe is precies wat Toby Ord bedoelt als hij stelt dat we de coronacrisis moeten aangrijpen om na te denken over beslissingen aangaande de toekomst; beslissingen met de hoogste prioriteit omdat het voortbestaan van de mens er volgens hem van afhangt.

Ord houdt een slag om de arm als het op kansberekening aankomt. Hij schat de kans dat de mensheid de 21 e eeuw niet overleeft in op een op zes. Wordt er voorbijgegaan aan het risico van AGI dan wordt dat volgens hem een op drie. Nemen we de dreiging volledig ter harte dan kan het volgens hem echter teruggebracht worden tot een op honderd. Welke politicus staat daar nu bij stil?

Veel, zo niet alles, hangt zoals gesteld af van de normen en waarden waar AGI mee geprogrammeerd wordt. Met die constatering is dit artikel echter terechtgekomen bij een thema dat een veel uitgebreidere introductie behoeft. Een indruk van ander lokaas dat de cybertoekomst ons toewerpt bijvoorbeeld.